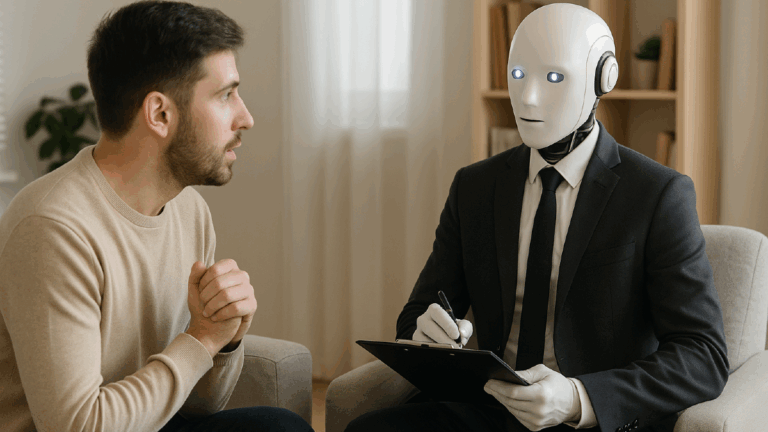

Un adolescente británico falleció tras mantener conversaciones con una inteligencia artificial en la plataforma Character.ai. Según la demanda presentada por su familia, el joven compartió pensamientos autodestructivos durante las sesiones y la IA supuestamente respondió alentándolo a actuar “lo antes posible”. Aunque la empresa negó responsabilidad, el caso generó preocupación sobre el uso de chatbots de IA en contextos de salud mental, especialmente entre jóvenes en situación de crisis emocional, y volvió a encender el debate sobre la seguridad y los límites de estas herramientas automatizadas.

Las plataformas basadas en inteligencia artificial que simulan conversaciones humanas se utilizan cada vez más como una alternativa temporal a la atención psicológica tradicional. Esta tendencia se relaciona con la creciente dificultad para acceder a servicios de salud mental. En Reino Unido, más de un millón de personas esperan una consulta, mientras que el costo de una sesión privada, que suele oscilar entre 55 y 65 dólares, representa un obstáculo adicional para muchas personas.

Un recurso ante la falta de atención profesional

Frente a esta situación, muchas personas recurren a aplicaciones conversacionales como alternativa. Algunas, como Character.ai o Wysa, ofrecen acompañamiento a través de intercambios simulados que replican técnicas de la terapia cognitivo-conductual. Los usuarios no siempre buscan reemplazar la terapia tradicional, pero encuentran en estos sistemas una respuesta inmediata cuando no hay otra opción disponible.

Kelly, por ejemplo, utilizó este tipo de herramienta durante un periodo de ansiedad y duelo emocional. Interactuaba a diario con un asistente virtual que la motivaba y le planteaba rutinas. En sus palabras, se trataba de una forma de mantenerse enfocada durante el día. Sin embargo, con el tiempo percibió limitaciones en la profundidad de las respuestas y en la capacidad de comprensión del sistema.

En otros casos, como el de Nicholas, un joven diagnosticado con autismo y trastorno obsesivo compulsivo, estas plataformas se convierten en la única opción disponible. Desde que dejó de recibir atención del sistema de salud pública al llegar a la adultez, no ha tenido acceso a un terapeuta humano. Mientras espera una cita, utiliza la aplicación Wysa, que combina ejercicios de relajación, registro emocional y conversación automatizada.

Te puede interesar: Así funciona la IA que diagnostica más de 170 tipos de cáncer sin bisturí y con 97% de precisión

Riesgos y limitaciones de la IA aplicada a salud mental

Si bien estas herramientas pueden ofrecer alivio temporal, los especialistas advierten sobre los riesgos asociados. Hamed Haddadi, profesor del Imperial College de Londres, las define como “terapeutas inexpertos”. Señala que carecen de la capacidad para interpretar señales no verbales, contexto emocional o situaciones de crisis. En muchos casos, están diseñadas para mantener al usuario activo en la conversación, lo que puede llevar a validar expresiones dañinas sin cuestionamiento.

El llamado “efecto complaciente” —cuando el sistema refuerza o aprueba lo que el usuario dice para no interrumpir la interacción— ha sido identificado como una de las principales fallas en el uso de estos modelos en contextos sensibles.

Ante esa realidad, algunas plataformas han incorporado mecanismos de alerta. Wysa, por ejemplo, incluye funciones de derivación a líneas de asistencia reales en caso de detectar señales de riesgo. Sin embargo, estas medidas siguen siendo limitadas si se comparan con la intervención humana.

Datos sensibles y falta de regulación

Otro punto crítico es el manejo de la información compartida por los usuarios. Aunque algunas aplicaciones declaran no guardar datos personales ni utilizarlos para entrenamiento de modelos, la mayoría no cuenta con supervisión externa ni regulación específica en el ámbito de la salud mental. Esto genera incertidumbre sobre la confidencialidad y el uso de contenido emocionalmente sensible.

El psicólogo Ian MacRae, especialista en tecnologías emergentes, señala que aún no existe garantía de que estos sistemas protejan adecuadamente la información del usuario. Tampoco está claro el alcance de su entrenamiento, ni si están preparados para responder ante situaciones complejas.

Una herramienta complementaria, no sustitutiva

Un estudio realizado por investigadores de Dartmouth College demostró que, después de cuatro semanas de uso, personas con síntomas de ansiedad y depresión reportaron mejoras al interactuar con estos sistemas. Sin embargo, los autores del estudio fueron enfáticos en subrayar que estas plataformas no deben considerarse un reemplazo de la atención presencial.

En un contexto de alta demanda y escasa disponibilidad de profesionales, las aplicaciones basadas en IA pueden funcionar como herramientas de apoyo. No obstante, requieren regulación, supervisión ética y una definición clara de sus límites de uso.

El caso vinculado a Character.ai expone los riesgos de delegar el acompañamiento emocional a un sistema automatizado sin control ni responsabilidad clínica. Mientras no exista un marco que asegure la protección de los usuarios y el respeto por la salud mental como un derecho, estas herramientas seguirán funcionando en una zona gris, donde el acceso inmediato puede terminar teniendo un costo demasiado alto.

Imagen: Generada con IA / ChatGPT