Un equipo de neurocientíficos, neurocirujanos e ingenieros de la Universidad Duke de Carolina del Norte, Estados Unidos, creó una prótesis que puede traducir las señales cerebrales de una persona que ha perdido el habla debido a trastornos neurológicos.

Es decir, el nuevo dispositivo sería capaz de leer los pensamientos de aquellas personas que no pueden hablar debido a trastornos neurológicos para recuperar la capacidad de comunicarse a través de una interfaz cerebro-computadora.

Los resultados de la investigación fueron publicados este 6 de noviembre en la revista científica Nature Communications. De acuerdo con Gregory Cogan, Ph.D, de neurología en la Facultad de Medicina, hay muchos pacientes que sufren trastornos motores debilitantes, como ELA (esclerosis lateral amiotrófica) o síndrome de enclaustramiento, que pueden afectar su capacidad para hablar, ante esto actualmente existen algunas herramientas que ayudan a comunicar, sin embargo generalmente son muy lentas y engorrosas.

Te puede interesar: Científicos de la UNSW Sydney crean tejido humano ¿Cuál sería su uso?

Los científicos explican que esto es como escuchar un audiolibro a media velocidad. Esa es la mejor velocidad de decodificación de voz disponible actualmente, que alcanza aproximadamente 78 palabras por minuto . Sin embargo, la gente habla alrededor de 150 palabras por minuto.

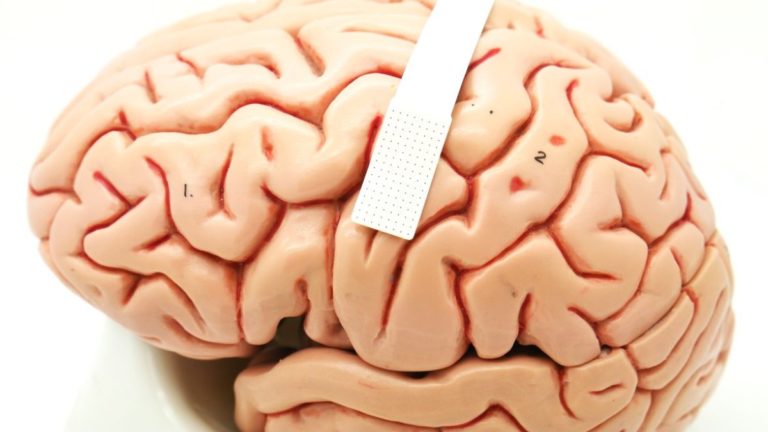

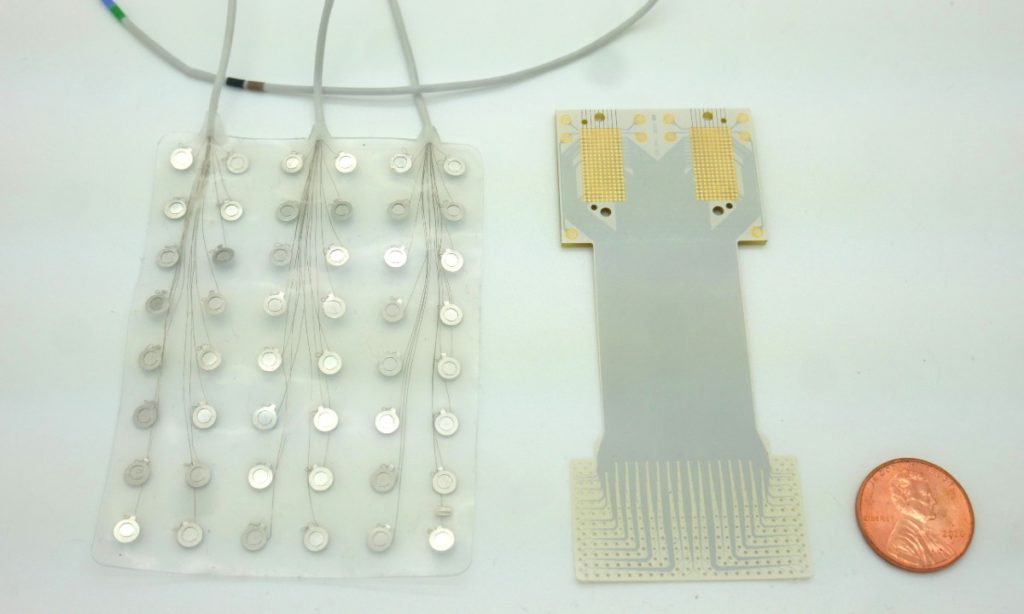

El retraso entre las velocidades del habla hablada y decodificada se debe en parte a los relativamente pocos sensores de actividad cerebral que pueden fusionarse en una pieza de material delgada como un papel que se encuentra sobre la superficie del cerebro. Menos sensores proporcionan información menos descifrable para decodificar.

Ante este panorama Cogan se asoció con Jonathan Viventi, Ph.D., miembro de la facultad del Instituto Duke de Ciencias del Cerebro, cuyo laboratorio de ingeniería biomédica se especializa en fabricar sensores cerebrales de alta densidad, ultrafinos y flexibles.

Para este proyecto, Viventi y su equipo empaquetaron la impresionante cantidad de 256 sensores cerebrales microscópicos en una pieza de plástico flexible de grado médico del tamaño de un sello postal.

Te puede interesar: Biopsias serían hechas por estos micro-robots blandos, ¿Cuál es su potencial médico?

Las neuronas que están a sólo un grano de arena de distancia pueden tener patrones de actividad tremendamente diferentes al coordinar el habla, por lo que es necesario distinguir las señales de las células cerebrales vecinas para ayudar a hacer predicciones precisas sobre el habla prevista.

Después de fabricar el nuevo implante, reclutaron a cuatro pacientes para probar los implantes. El experimento requirió que los investigadores colocaran el dispositivo temporalmente en pacientes que se sometían a una cirugía cerebral por alguna otra afección, como el tratamiento de la enfermedad de Parkinson o la extirpación de un tumor.

La tarea consistía en una simple actividad de escuchar y repetir. Los participantes escucharon una serie de palabras sin sentido, como “ava”, “kug” o “vip”, y luego pronunciaron cada una de ellas en voz alta.

El dispositivo registró la actividad de la corteza motora del habla de cada paciente mientras coordinaba casi 100 músculos que mueven los labios, la lengua, la mandíbula y la laringe.

Te puede interesar: Estudio revela cómo afecta el celular al semen y la fertilidad masculina

Luego tomaron los datos neuronales y del habla de la sala de cirugía y los introdujo en un algoritmo de aprendizaje automático para ver con qué precisión podía predecir qué sonido se estaba emitiendo realizado, basándose únicamente en los registros de la actividad cerebral.

Para algunos sonidos y participantes, como /g/ en la palabra “gak”, el decodificador acertó el 84% de las veces cuando era el primer sonido de una cadena de tres que formaba una palabra sin sentido determinada.

Sin embargo, la precisión disminuyó cuando el decodificador analizó los sonidos en el medio o al final de una palabra sin sentido. También tuvo problemas si dos sonidos eran similares, como /p/ y /b/.

En general, el decodificador fue preciso el 40% del tiempo. Puede parecer una puntuación de prueba humilde, pero fue bastante impresionante dado que proezas técnicas similares del cerebro al habla requieren horas o días de datos para extraerlos. Sin embargo, el algoritmo de decodificación de voz que utilizó Duraivel funcionó con sólo 90 segundos de datos hablados de la prueba de 15 minutos.

Te puede interesar: Investigador colombiano desarrolló algoritmo que identifica enfermedad en cultivos de papa: un alivio para agricultores

Duraivel y sus mentores están entusiasmados con la idea de fabricar una versión inalámbrica del dispositivo con una reciente subvención de 2,4 millones de dólares de los Institutos Nacionales de Salud.

“Ahora estamos desarrollando el mismo tipo de dispositivos de grabación, pero sin cables”, dijo Cogan. “Podrías moverte y no tendrías que estar atado a un tomacorriente, lo cual es realmente emocionante”.