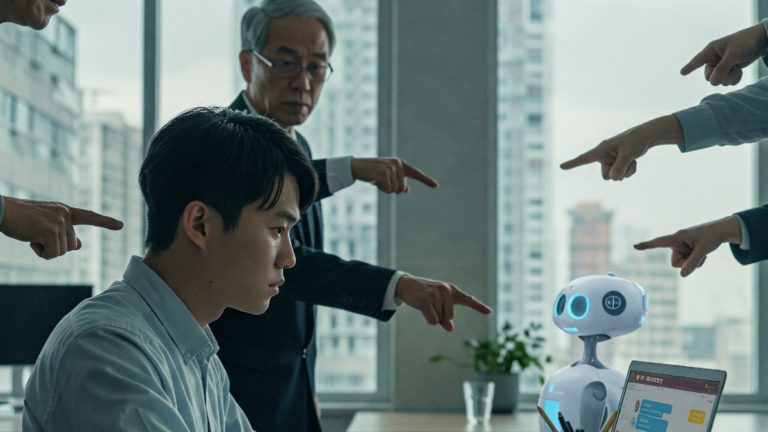

Un reciente estudio de la Universidad de Duke, publicado en la revista PNAS, revela una paradoja incómoda en el mundo laboral contemporáneo, quienes usan herramientas de inteligencia artificial (IA) como ChatGPT o Gemini pueden ser vistos como menos competentes y más perezosos por sus colegas y supervisores.

El hallazgo pone en evidencia un estigma emergente; aunque la IA promete mejorar la productividad y optimizar tareas repetitivas, su uso puede implicar un “castigo social” inesperado. Así lo concluyeron los investigadores Jessica A. Reif, Richard P. Larrick y Jack B. Soll tras analizar los resultados de cuatro experimentos con más de 4.400 participantes.

En la primera parte del estudio, se les pidió a empleados imaginar que usaban una herramienta de IA para facilitar su trabajo. La mayoría expresó reticencia a contarle a sus jefes o compañeros que recurrían a esta tecnología. Temían ser percibidos como flojos, prescindibles o faltos de compromiso profesional.

Los temores estaban justificados. En la segunda fase, cuando observadores evaluaban a colegas que usaban IA, los calificaban de forma sistemáticamente más negativa que a quienes recibían ayuda humana o no recibían ayuda alguna. La penalización era clara: menor percepción de competencia, esfuerzo e independencia.

Te puede interesar: El otro lado de la IA: ¿Por qué persiste la resistencia al uso de la inteligencia artificial?

Los prejuicios no distinguieron entre género, edad u ocupación. El sesgo fue generalizado, lo que sugiere que el problema no radica en el tipo de tarea ni en el perfil del usuario, sino en el hecho mismo de utilizar IA.

Una de las pruebas más reveladoras involucró decisiones de contratación. A un grupo de “gerentes” se les pidió elegir candidatos para una tarea específica. Aquellos que sabían que un postulante usaba IA diariamente lo contrataban con menor frecuencia que a quienes no usaban estas herramientas. Curiosamente, este efecto se diluía si el gerente también era usuario habitual de IA.

Esto plantea una situación contradictoria: quienes usan IA para trabajar mejor podrían estar perjudicando su imagen frente a quienes aún no han adoptado esta tecnología. Como lo describe el estudio, la percepción de “ayuda artificial” activa procesos mentales que llevan a atribuir menos mérito al trabajador.

El cuarto experimento arrojó una luz al final del túnel. Si se aclaraba que la tarea era digital y que la IA era útil para ejecutarla, el estigma desaparecía. En cambio, cuando la tarea era manual o tradicional, el usuario de IA seguía siendo visto como poco apto. Esto sugiere que la clave está en cómo se presenta el uso de la tecnología: si se alinea con la necesidad, puede ser valorada; si parece un atajo innecesario, se penaliza.

El análisis, sustentado en la teoría de la atribución, plantea una implicación organizacional importante: la resistencia a la IA no siempre proviene de la tecnología en sí, sino de las normas sociales que regulan su uso. En entornos donde el esfuerzo personal es un valor medular, cualquier herramienta que sugiera dependencia puede resultar problemática.

Te puede interesar: ChatGPT se conecta a GitHub: así funcionará esta nueva herramienta para desarrolladores

Cabe mencionar que el estudio de Duke alerta sobre un obstáculo subestimado para la adopción de IA en el trabajo: el temor a ser mal juzgado. Para los empleados, se trata de un dilema entre mejorar resultados y cuidar la imagen. Para las organizaciones, el reto es crear culturas que valoren la eficiencia sin castigar la innovación.

¿La solución? Promover el uso transparente de IA, fomentar la alfabetización tecnológica entre todos los rangos y reconocer que, en muchos casos, saber usar bien una herramienta también es un signo de inteligencia. No solo artificial.

Imagen: Generada con IA